Discrimination algorithmique à la CAF: un atelier pour faire deviner les critères problématiques

Que ce soit pour le calcul des bénéfices sociaux ou lors de processus d’embauche, nous sommes de plus en plus confrontés à des algorithmes obscurs et discriminants. La compréhension de ces systèmes est bien souvent la plus limitée parmi ceux qui sont les plus ciblés et discriminés. Cet effet de ciseau a été mis en évidence par de nombreux militants. Par exemple, en France, quinze organisations de la société civile ont récemment attaqué la CNAF (Caisse nationale des allocations familiales) devant le Conseil d’Etat pour abroger un algorithme attribuant un score de risques aux allocataires et ciblant les plus vulnérables dans les contrôles. Dans le même temps, la Défenseur des Droits a publié un rapport qui propose des pistes d’améliorations au sujet de la transparence des algorithmes.

Tous les travailleurs de l'inclusion numérique — qu'ils soient aidants, médiateurs, travailleurs sociaux, etc., en prise avec l'automatisation des services publics ou fonctionnaires — doivent faire face à des demandes croissantes de leurs publics concernant les systèmes algorithmiques.

Pour mieux informer ces professionnels à ce sujet, Datactivist, et les associations militantes Changer de Cap et Pas Sans Nous 38 (Isère) se sont mobilisées le 19 mars 2025 lors d’un atelier pratique. Cette session est organisée dans le cadre du projet européen Algo->Lit qui vise à former les médiateurs numériques afin de les aider à expliquer les algorithmes et à accompagner leurs publics dans l’utilisation de leurs droits à l’information à propos de ces systèmes.

Le support complet de l'atelier est ici : Atelier score de risques V2.pdf

Le support complet de l'atelier est ici : Atelier score de risques V2.pdf

Jaoued Doudouh, militant des quartiers populaires au sein de l’association Pas Sans Nous 38 a introduit la journée avec la lecture d’un texte inspiré qu’il a écrit pour adresser une critique des algorithmes depuis une perspective décoloniale :

“Aujourd’hui, nous abordons une réalité cruciale, souvent ignorée mais profondément ancrée dans nos vies : les algorithmes discriminants. Pour nous, militants et porte-voix des quartiers populaires, aux côtés des personnes précaires, vivant dans la rue, migrantes ou âgées, cet enjeu dépasse largement la dimension technologique. Il touche directement à notre dignité collective, à notre existence même.

Brutalité numérique et colonialisme technologique

Depuis longtemps, les quartiers populaires et les populations marginalisées sont devenus, souvent malgré eux, des laboratoires pour ces logiques algorithmiques. Nous subissons une brutalité numérique subtile mais profondément violente, où chacun est réduit à des données, des chiffres, des statistiques et des prédictions sécuritaires. Cette dynamique rejoint le « brutalisme » décrit par Achille Mbembe (2020), cette logique froide et calculatrice qui réduit tout vivant, toute complexité humaine à quelque chose de strictement mesurable, contrôlable et exploitable. Cette logique constitue une forme contemporaine de colonialisme technologique, héritière directe des systèmes coloniaux historiques analysés par Frantz Fanon (1961), visant à ordonner, classifier et gérer les populations perçues comme problématiques ou inutiles. Dans nos quartiers, dans la rue, dans les centres d'accueil pour migrants ou les établissements pour personnes âgées, cette logique se manifeste par l’intensification dramatique du contrôle social automatisé : reconnaissance faciale, vidéosurveillance prédictive, algorithmes d’attribution des logements, contrôle automatisé des aides sociales, gestion automatisée du vieillissement et de la santé. Ces systèmes ne perçoivent plus les individus comme des êtres humains, mais uniquement comme des risques à gérer, des anomalies à corriger ou des menaces à anticiper (Eubanks, 2018; Benjamin, 2019).

Par exemple, depuis 2021, plusieurs collectivités territoriales françaises utilisent des systèmes automatisés pour l’attribution des logements sociaux. Des recherches menées par la Défenseur des Droits (2022) montrent que ces systèmes reproduisent massivement les discriminations existantes, pénalisant particulièrement les familles issues des quartiers populaires. De même, des expérimentations de vidéosurveillance prédictive à Marseille et Nice, toujours dénoncées par La Quadrature du Net, utilisent des algorithmes dénoncés pour leurs biais raciaux et sociaux systématiques, accentuant la stigmatisation des populations racisées (Amnesty International, 2021).

Écocide et surveillance généralisée

Cette dynamique est également liée au concept d’« écocide » développé par Mbembe (2020), à savoir une destruction programmée non seulement du vivant naturel, mais aussi du vivant humain, social et culturel. Elle détruit méthodiquement nos liens sociaux, nos solidarités, notre créativité artistique, limitant ainsi notre capacité à imaginer une société fondée sur autre chose que la logique du profit et de la surveillance généralisée (Zuboff, 2019). La numérisation accélérée de la société amplifie davantage ces discriminations. Loin d’être neutre, elle instaure un ordre technocratique autoritaire imposant partout une logique algorithmique déshumanisante dans les domaines essentiels : logement, santé, emploi, éducation, sécurité, accès aux droits sociaux fondamentaux. Les individus sont constamment évalués, classés et triés selon des intérêts économiques et sécuritaires précis. Les institutions utilisent ces outils pour masquer leur responsabilité politique, rendant opaques et déresponsabilisées les décisions qui concernent pourtant directement nos vies (Morozov, 2013; Crawford, 2021). Dans le contexte actuel d’une Europe instable, confrontée à des crises multiples et profondes, cette logique sécuritaire et technologique se radicalise. Face à la montée des tensions géopolitiques, des conflits ouverts ou latents et d’une course inquiétante au réarmement, l'Europe réoriente ses priorités dans une urgence sécuritaire sans précédent. Le numérique et les algorithmes occupent une place centrale dans cette dynamique, utilisés comme outils privilégiés pour surveiller, contrôler et prédire les comportements sociaux à grande échelle. Cette réorientation produit une militarisation progressive de la société civile où les technologies de surveillance algorithmiques deviennent des instruments de contrôle social généralisé (Lyon, 2018; Amoore, 2013). Un exemple stratégique récent est la loi relative aux Jeux Olympiques de Paris 2024, prévoyant l’utilisation massive de la reconnaissance faciale et de l’analyse comportementale automatisée. Ce dispositif soulève des inquiétudes majeures concernant les biais algorithmiques, le profilage ethnique et une suspicion généralisée des comportements jugés « suspects », constituant un précédent majeur en matière de sécurité algorithmique en Europe (Ligue des droits de l'Homme, 2023).

Résistances et alternatives

Ainsi, un aspect essentiel, souvent ignoré mais fondamental dans ma réflexion, concerne les résistances internes programmées dans les outils numériques eux-mêmes. Ces résistances intégrées, cette autocensure algorithmique et neutralité imposée révèlent comment ces outils sont conçus pour servir avant tout les intérêts dominants de leurs concepteurs. La critique radicale de la technologie inclut nécessairement cette analyse profonde du modèle économique et politique qui la sous-tend (Morozov, 2013). La résistance que nous menons aujourd’hui depuis les quartiers populaires, aux côtés des précaires, des migrants, des sans-abris et des personnes âgées, est donc existentielle. Elle vise à réinscrire les outils technologiques dans un véritable récit d’émancipation et de libération, plutôt que de soumission et d’oppression. Défendre cette vision, c’est affirmer radicalement que l’humain ne sera jamais réductible à une fonction calculable, que notre dignité ne sera jamais négociable face aux impératifs du profit numérique. C’est promouvoir une écologie populaire où le vivant humain, social et culturel échappe définitivement à la réduction algorithmique.”

Après cette introduction, les thèmes suivants ont été introduits par Loup Cellard, chercheur à Datactivist :

- ce qu'est un algorithme ;

- pourquoi c'est important de savoir comment l'Etat et les administrations utilisent des systèmes de calculs ;

- le cadre législatif qui garantit notre droit à l'information à leurs propos ;

- des exemples illustrant les enjeux soulevés par l'utilisation des algorithmes.

Les slides sont disponibles ici : Intro Algo.pdf

Les slides sont disponibles ici : Intro Algo.pdf

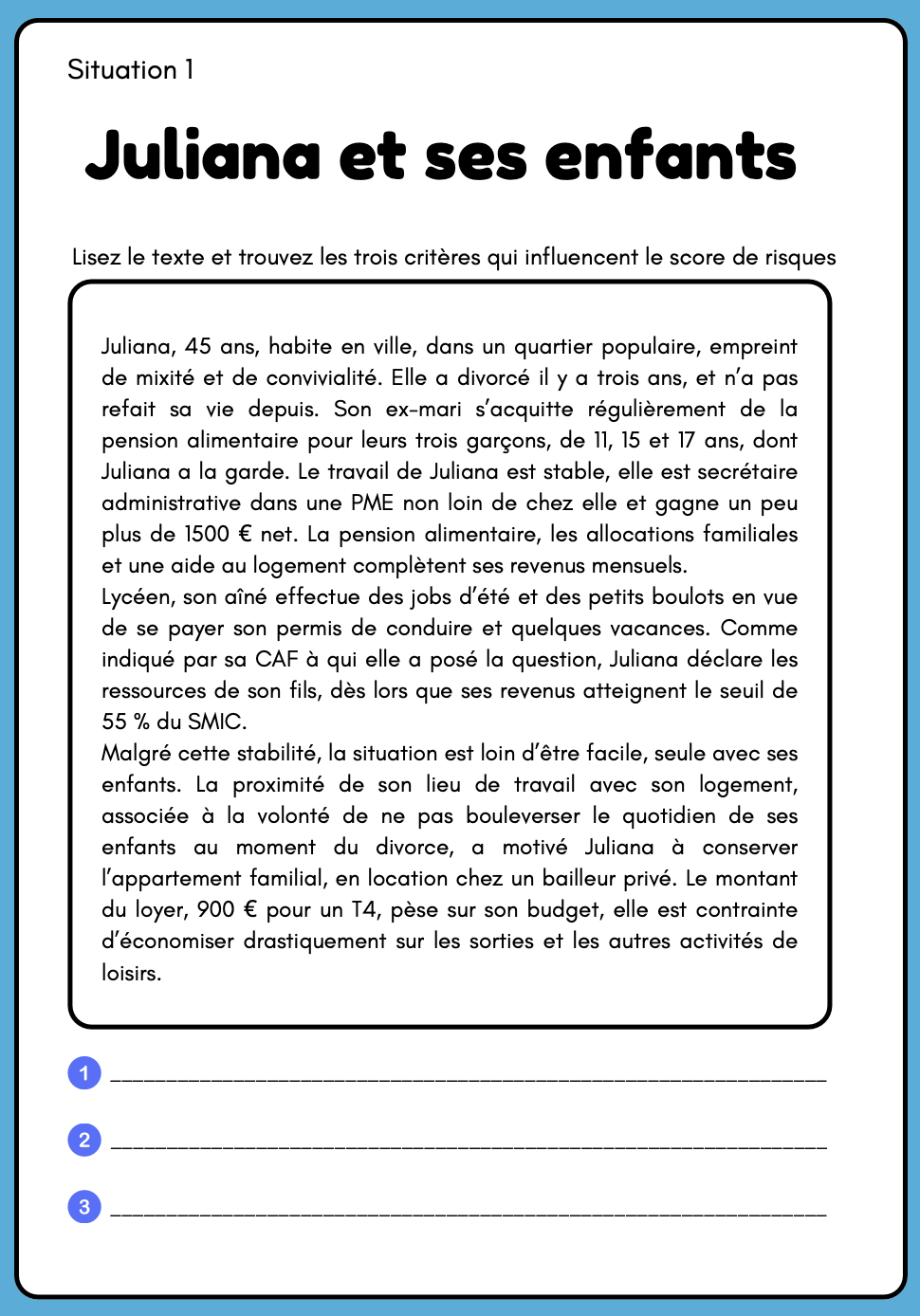

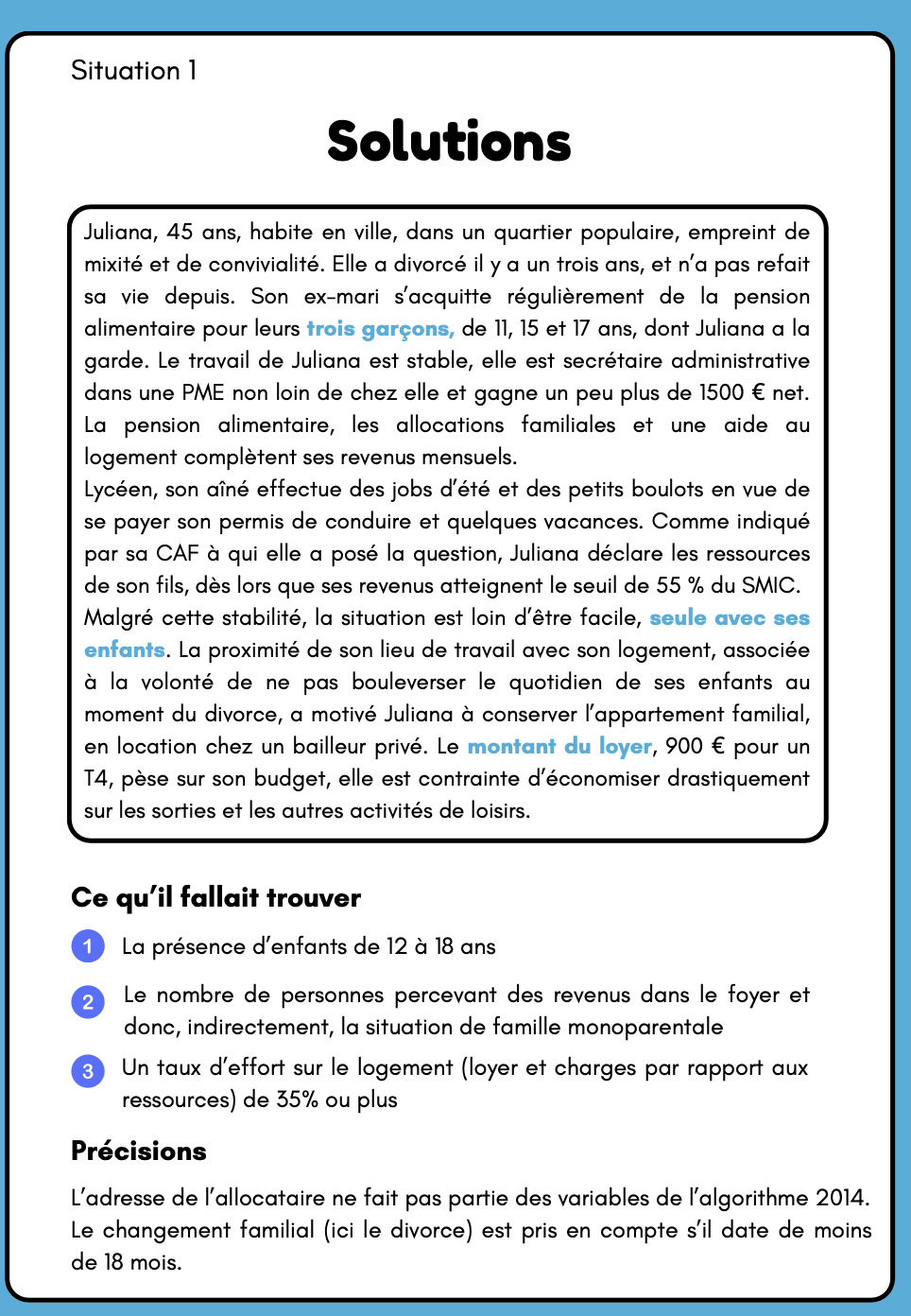

Enfin, la dernière demie-heure de l'atelier a été consacrée à un exercice : faire deviner les critères problématiques de l’algorithme de score de risques de la CNAF. En effet, dans les CAF, un algorithme de notation attribue des scores de risques à tous les allocataires, quelles que soient les prestations versées (aide au logement, allocations familiales, prime d’activité, RSA, allocation adulte handicapé…). Plus son score de risques est élevé, plus un allocataire a de risque de subir un contrôle, car il est davantage soupçonné d’avoir commis des erreurs ou une fraude. La notation s’effectue selon des critères (ou « variables ») choisis par la CNAF, de même que leur pondération, parmi les milliers de données que détiennent les CAF sur chacun de leurs allocataires. L’étude de l’algorithme de notation 2014 a démontré que celui-ci cible délibérément les plus vulnérables. Un recours en Conseil d’État a été déposé par quinze organisations en octobre 2024 pour réclamer son abrogation.

L’atelier pratique se déroulait de la manière suivante : trois situations familiales étaient présentées, chacune contenant trois critères qui font augmenter le score de risques attribués aux allocataires. Il s’agit de variables retenues parmi les 94 de la version 2014-2018 de l’algorithme, la seule qu’ont pu obtenir les associations et les médias. Les participants étaient invités à trouver ces trois critères à travers la lecture d’une description de la situation familiale. Ci-dessous vous trouverez une des situations familiales suivie de la correction de l’exercice.

Ces systèmes algorithmes, qu’ils servent à calculer et attribuer des droits ou à contrôler des allocataires, sont soumis à des obligations souvent non respectées en matière d’impact et de transparence. La sur-utilisation des données personnelles (contraire au principe de minimisation du RGPD) et la discrimination indirecte sont ainsi au coeur du recours déposé devant le Conseil d’Etat contre l’algorithme de notation de la CNAF par quinze associations. Défendre l’accès des citoyens à ces algorithmes, qui s’apparentent aujourd’hui à des boîtes noires, est un enjeu démocratique. Il est porté collectivement par des organisations. Il ne faut pas pour autant oublier les droits individuels que peuvent faire valoir les usagers/allocataires/administrés, aidés au besoin par leurs accompagnants sociaux et associatifs : accès aux données personnelles, droit de rectification, droit à l’explication du calcul, notamment.

Au sein du projet Algo->Lit, nous souhaitons continuer à mener ce type d’atelier avec des médiateurs numériques — qu’ils soient professionnels de l’inclusion, travailleurs sociaux ou militants — pour, à terme, construire les formations et les outils dont ils ont besoin. Notre objectif est qu’ils puissent ensuite expliquer à leurs publics comment faire face aux algorithmes, aux décisions qu’ils engendrent et à leurs conséquences bien concrètes. Bien que peu respectés et méconnus, nous avons des droits face aux systèmes algorithmiques.

Pour plus d’information à ce propos : algolit(at)datactivi.st, mj.doudouh(at)hotmail.fr, valerie.changerdecap(at)protonmail.com.

Pour plus d’information sur le projet Algo->Lit: algolit(at)datactivi.st